De nieuwe chatbot van Deepseek, die moedig verklaarde: "Hallo, ik ben gemaakt zodat je alles kunt vragen en een antwoord kunt krijgen dat je misschien zou kunnen verrassen", heeft belangrijke golven gemaakt in de AI -industrie. Deze introductie heeft niet alleen de aandacht getrokken, maar heeft ook bijgedragen aan een van de grootste aandelenkoersdaling van Nvidia, met de impact van Deepseek op de markt.

Afbeelding: ensigame.com

Afbeelding: ensigame.com

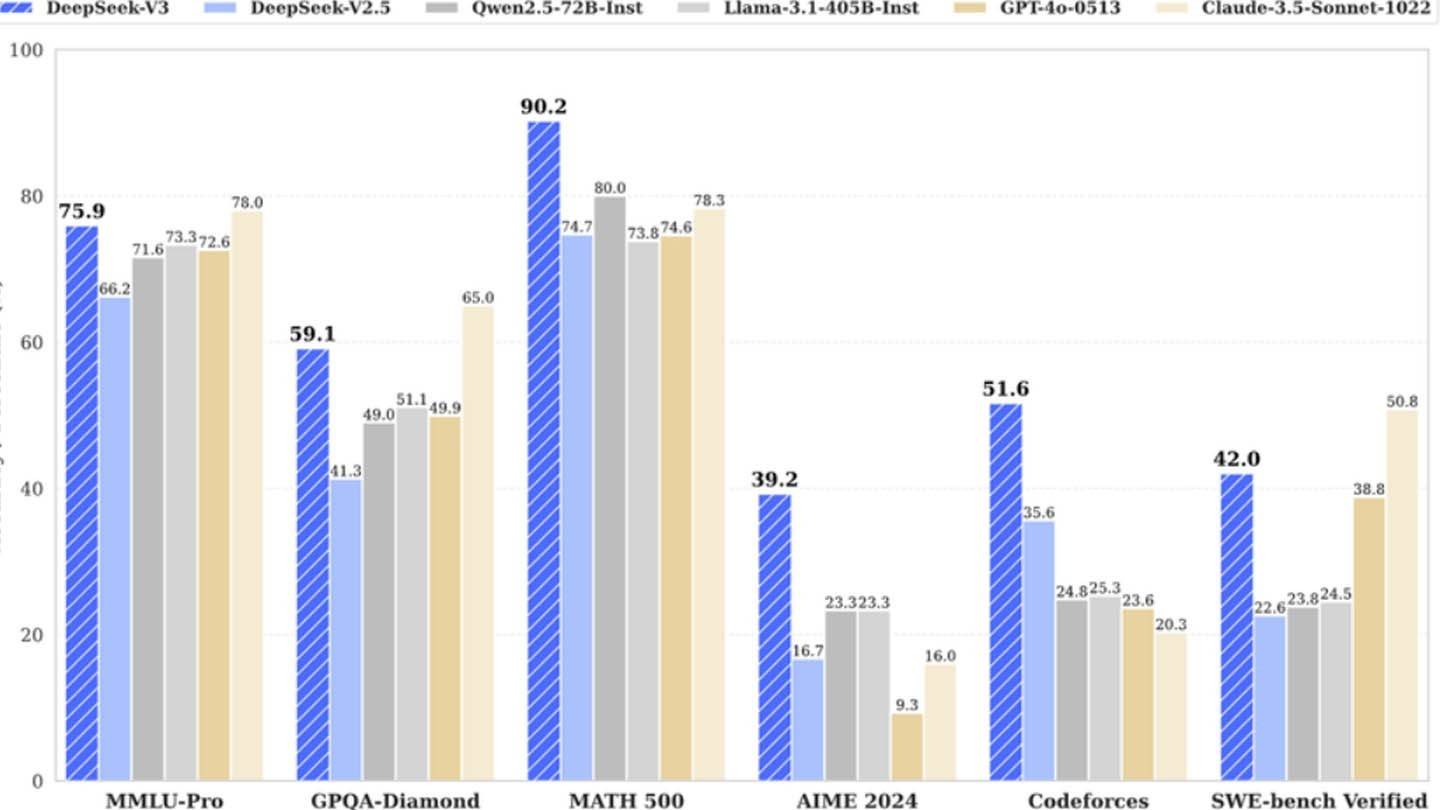

Het AI -model van Deepseek onderscheidt zich vanwege de innovatieve architectuur- en trainingsmethoden. Laten we duiken in de belangrijkste technologieën die het onderscheiden:

Multi-token voorspelling (MTP) : deze methode stelt het model in staat om meerdere woorden tegelijk te voorspellen door verschillende segmenten van een zin te analyseren. Dit verhoogt niet alleen de nauwkeurigheid, maar ook de efficiëntie van het model, waardoor het een krachtig hulpmiddel is voor het begrijpen en genereren van tekst.

Mix van experts (MOE) : Deepseek V3 maakt gebruik van een geavanceerde architectuur met 256 neurale netwerken, waarbij acht worden geactiveerd voor elke tokenverwerkingstaak. Deze aanpak versnelt de AI -training aanzienlijk en verbetert de algehele prestaties, waardoor het een opvallende functie van hun technologie is.

Multi-head latente aandacht (MLA) : dit mechanisme richt zich op de meest cruciale delen van een zin en extraheren herhaaldelijk belangrijke details. Door dit te doen, vermindert MLA het risico op het missen van belangrijke informatie, waardoor de AI genuanceerde details in de invoergegevens effectief kan vastleggen.

Deepseek, een prominente Chinese startup, beweert dit concurrerende AI -model te hebben ontwikkeld tegen relatief lage kosten. Ze beweren dat het trainen van het krachtige Deepseek V3 Neural Network hen slechts $ 6 miljoen kostte en slechts 2048 grafische processors gebruikten.

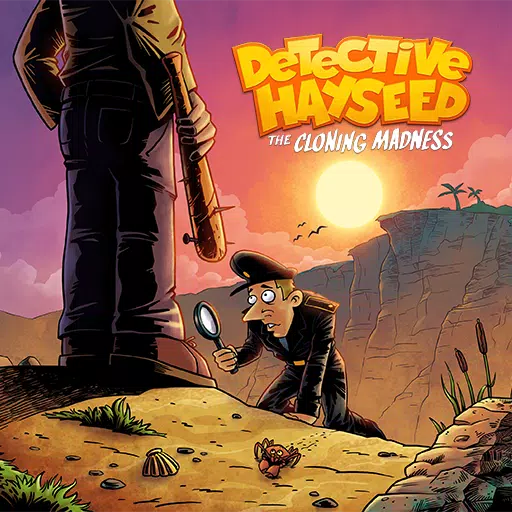

Afbeelding: ensigame.com

Afbeelding: ensigame.com

Analisten van Semianalysis hebben echter ontdekt dat de operaties van Deepseek een veel grotere computationele infrastructuur inhouden. Ze schatten dat Deepseek ongeveer 50.000 Nvidia Hopper GPU's gebruikt, waaronder 10.000 H800 -eenheden, 10.000 H100's en extra H20 GPU's, verspreid over verschillende datacenters. Deze middelen worden gebruikt voor AI -training, onderzoek en financiële modellering, waarbij de totale investering van het bedrijf in servers ongeveer $ 1,6 miljard en operationele kosten bereikt op $ 944 miljoen.

Deepseek is een dochteronderneming van het Chinese hedgefonds High-Flyer, dat het in 2023 als een afzonderlijke AI-gerichte divisie heeft gevestigd. In tegenstelling tot veel startups die afhankelijk zijn van cloud computing, bezit Deepseek zijn datacenters, waardoor het volledige controle krijgt over AI-modeloptimalisatie en snellere innovatie-implementatie. De zelf gefinancierde status van het bedrijf verbetert zijn behendigheid en besluitvormingssnelheid.

Afbeelding: ensigame.com

Afbeelding: ensigame.com

Bovendien trekt Deepseek toptalent aan van toonaangevende Chinese universiteiten, waarbij sommige onderzoekers jaarlijks meer dan $ 1,3 miljoen verdienen. Ondanks deze belangrijke investeringen lijkt de claim van het bedrijf om zijn nieuwste model voor slechts $ 6 miljoen te trainen onrealistisch, omdat dit cijfer alleen GPU-gebruik tijdens pre-training verklaart en andere substantiële kosten uitsluit zoals onderzoek, modelverfijning, gegevensverwerking en infrastructuur.

Sinds de oprichting heeft Deepseek meer dan $ 500 miljoen geïnvesteerd in AI -ontwikkeling. De compacte structuur stelt het in staat om AI -innovaties snel en effectief te implementeren, in tegenstelling tot grotere, meer bureaucratische bedrijven.

Afbeelding: ensigame.com

Afbeelding: ensigame.com

Het voorbeeld van Deepseek illustreert dat een goed gefinancierd, onafhankelijk AI-bedrijf kan concurreren met industriële reuzen. Hoewel het succes van het bedrijf wordt gedreven door substantiële investeringen, technische doorbraken en een sterk team, kan het idee van een "revolutionair budget" voor AI -modelontwikkeling te veel worden aangegeven. Desalniettemin blijven de kosten van Deepseek aanzienlijk lager dan die van zijn concurrenten, zoals de $ 100 miljoen uitgegeven aan het trainen van chatgpt4o in vergelijking met Deepseek's $ 5 miljoen voor R1.

Het is echter nog steeds goedkoper dan zijn concurrenten.

Thuis

Thuis  Navigatie

Navigatie

Laatste artikelen

Laatste artikelen

Nieuwste spellen

Nieuwste spellen